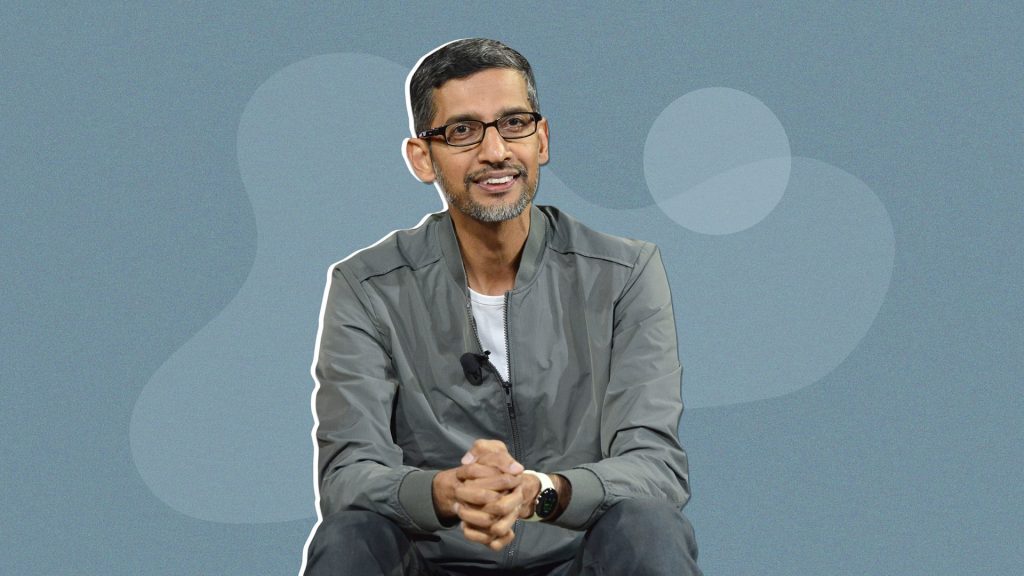

- Sundar Pichai, CEO-ul Alphabet, spune că inteligența artificială „este predispusă la erori” și nu trebuie tratată ca sursă absolută de adevăr

- Avertismentul vine după gafele celebre ale AI Overviews, care au recomandat lipici pe pizza sau să mănânci pietre

- Un studiu BBC arată că chatboții mari – de la Gemini la ChatGPT – oferă rezumate de știri cu erori majore

- Cercetători precum Gina Neff critică Big Tech pentru că pune responsabilitatea verificării pe utilizator, nu pe companie

- Google promite investiții mai mari în siguranța AI și lansează Gemini 3, dar admite că tehnologia se dezvoltă mai repede decât mecanismele de siguranță

Într-un interviu acordat BBC, Sundar Pichai transmite un mesaj pe cât de sincer, pe atât de necesar: nu luați de bune toate răspunsurile date de AI.

Motivul? Modelele actuale, inclusiv cele mai avansate, fac greșeli – și încă destul de des.

„Sunt instrumente puternice, dar trebuie folosite cu discernământ. AI-ul este predispus la erori”, spune șeful Google.

Cu alte cuvinte: foarte bun la creativitate, brainstorming sau cod, foarte riscant ca sursă de adevăr absolut.

Pichai insistă pe ideea unui „ecosistem bogat de informații”:

folosește AI-ul, dar verifică și prin căutări clasice, surse de presă, site-uri oficiale.

Un mesaj… surprinzător, venind de la compania care vrea să integreze AI în aproape toate produsele sale.

De la glumă la problemă: când AI Overviews a luat-o razna

Dacă avertismentul lui Pichai sună prudent, istoria recentă a produselor Google îi dă dreptate.

AI Overviews – funcția care rezumă rezultatele din Google Search – a devenit celebră prin câteva momente monumentale de „creativitate”:

- a recomandat să pui lipici în pizza, pentru o crustă mai rezistentă,

- a sugerat că „uneori e sănătos să mănânci pietre”,

- a oferit răspunsuri eronate la întrebări banale de cultură generală.

Deși Google a promis corecții și filtrarea glumelor de pe Reddit, gafa a rămas în memoria colectivă, devenind „meme oficial” în competiția AI.

BBC confirmă: chatboții dau rateuri serioase la știri

Un studiu realizat de BBC a testat patru dintre cei mai folosiți chatboți – Gemini, ChatGPT, Copilot și Perplexity – dându-le articole reale de pe site-ul BBC.

Rezultatele sunt îngrijorătoare:

- peste jumătate dintre răspunsuri au avut probleme majore,

- aproximativ 20% au conținut erori factuale,

- circa 13% au inventat citate sau le-au modificat.

Asta nu înseamnă că AI-ul nu poate rezuma știri, ci că nu poate fi lăsat singur în cameră să facă asta fără verificare umană.

„Verificați voi ce spune AI-ul”? Experții nu sunt deloc convinși

Gina Neff, profesor de responsible AI, spune lucrurilor pe nume:

„Aceste sisteme inventează răspunsuri ca să ne mulțumească. Asta e periculos când vorbim despre sănătate, știință sau actualitate.”

Mai mult:

Neff acuză companiile Big Tech că aruncă responsabilitatea în cârca utilizatorilor:

„Nu poți să ceri oamenilor să verifice fiecare propoziție. Asta e responsabilitatea constructorului, nu a consumatorului.”

Mesajul e clar: AI-ul poate fi util, dar companiile nu se pot ascunde în spatele etichetelor „poate greși”.

Google își face temele: Gemini 3 și promisiuni de securitate

În paralel cu avertismentele, Pichai promovează lansarea Gemini 3, model conceput pentru:

- raționament mai bun,

- procesare multimodală (text, audio, video, imagini),

- înțelegere contextuală extinsă.

Google spune că investește în:

- tehnologii pentru detectarea imaginilor generate de AI,

- măsuri mai stricte de siguranță,

- echipe dedicate pentru testare și audit.

Totuși, Pichai admite că inovația se mișcă mai rapid decât protecția – iar asta e o problemă sistemică în industrie.

Cum folosim AI-ul fără să picăm în capcană

Dacă ar fi să extragem câteva „reguli de bun-simț” din poziția lui Pichai și avertismentele experților:

- AI-ul e excelent la generat idei – nu la verdict final.

- Orice informație critică trebuie verificată prin surse solide.

- Un ton încrezător nu garantează acuratețea.

- Nu folosi AI-ul pentru decizii medicale, financiare sau juridice.

- Când ai dubii, mergi la sursa originală.

Pe scurt: AI-ul poate fi genial… dar nu e un bibliotecar omniscient.