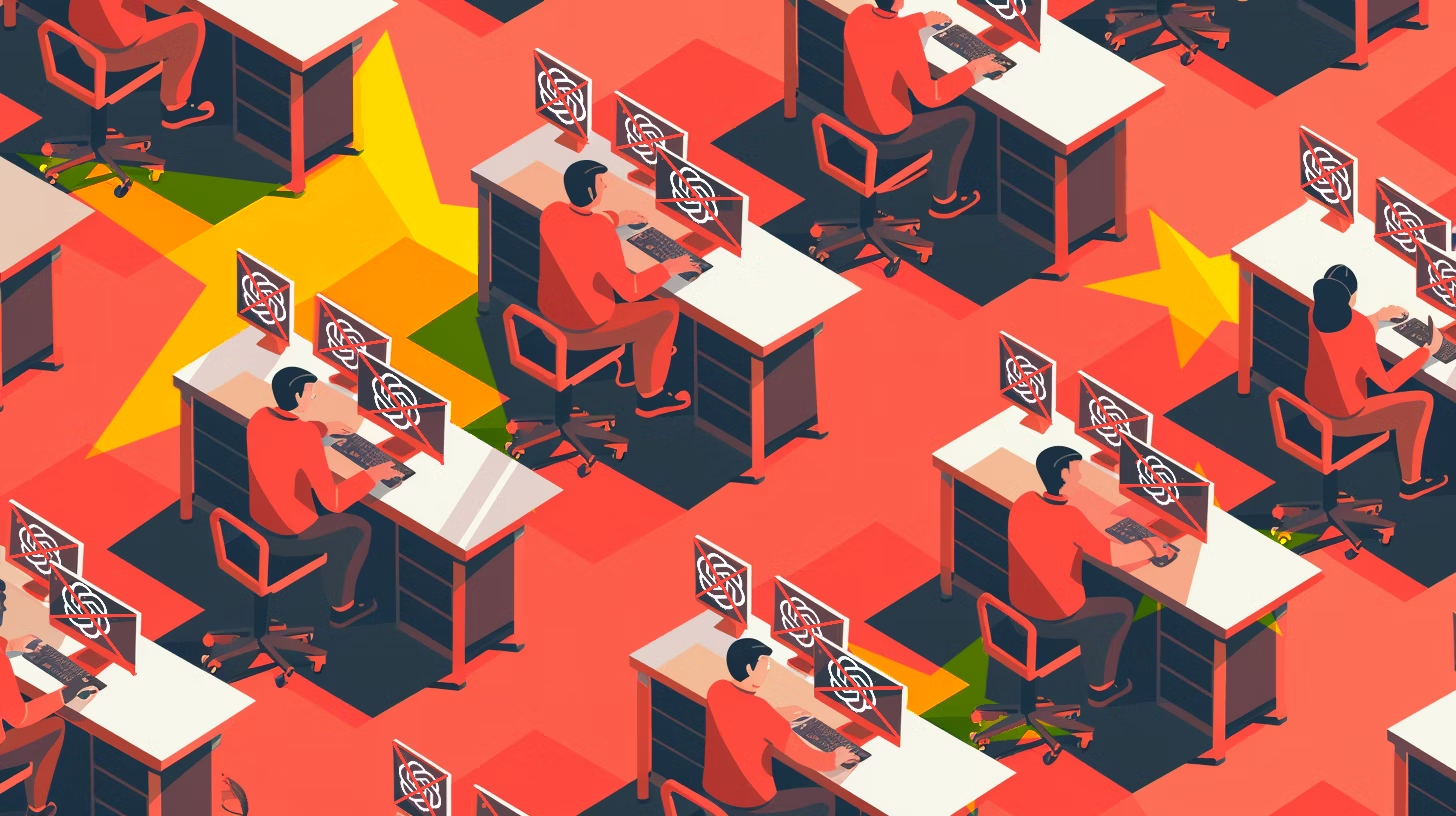

- OpenAI a interzis mai multe conturi ChatGPT cu legături chinezești pentru încercări de creare a instrumentelor de supraveghere online

- Alte conturi au fost implicate în phishing și dezvoltare de malware, unele asociate cu grupuri rusești

- Compania spune că nu există dovezi că modelele AI au fost folosite pentru atacuri avansate

- În total, peste 40 de rețele abuzive au fost demontate de OpenAI din 2024 până acum

- Incidentul amplifică rivalitatea SUA–China și evidențiază nevoia de reguli clare privind etica AI

Ceea ce părea o zi normală la sediul OpenAI din San Francisco s-a transformat într-o nouă demonstrație despre cât de serios tratează compania riscurile legate de folosirea abuzivă a inteligenței artificiale.

Advertisment

Marți, 7 octombrie, OpenAI a interzis mai multe conturi ChatGPT suspectate de legături cu entități guvernamentale din China, după ce utilizatorii au încercat să-l facă pe ChatGPT să propună instrumente de supraveghere social media.

„Unii utilizatori ne-au cerut să proiectăm sisteme de ‘ascultare’ a conversațiilor online — practic, idei pentru spionaj digital,” se arată în raportul de amenințări publicat de companie.

Pe scurt: ChatGPT a fost întrebat cum s-ar putea urmări și analiza populația.

Un AI cu principii

Ce a făcut OpenAI? A blocat conturile, a raportat incidentele și a clarificat că modelele sale nu vor fi niciodată transformate în instrumente de supraveghere.

Compania a identificat mai multe grupuri care încercau să folosească ChatGPT pentru phishing, dezvoltare de malware sau chiar pentru a automatiza anumite sarcini folosind DeepSeek, o platformă AI dezvoltată în China.

Interesant e că nu doar China a apărut în vizor.

OpenAI spune că a închis și conturi legate de grupuri criminale vorbitoare de rusă care încercau să folosească chatbotul pentru a crea programe malițioase.

„Am descoperit peste 40 de rețele care încercau să folosească modelele noastre în mod abuziv,” afirmă raportul.

Totuși, compania subliniază că nu există dovezi că AI-ul său a fost capabil să ofere tactici ofensive complet noi — semn că, pentru moment, ChatGPT rămâne un student model, nu un hacker.

Inteligență artificială, tensiuni reale

Măsura vine într-un context în care rivalitatea tehnologică dintre SUA și China s-a mutat direct în zona AI.

Statele Unite se tem că Beijingul ar putea folosi platforme occidentale pentru supraveghere internă și spionaj cibernetic, în timp ce China acuză Washingtonul de „discriminare tehnologică” și restricții abuzive la exportul de cipuri și software.

OpenAI, susținută de Microsoft, încearcă să arate că poate pune reguli etice ferme chiar și în fața presiunilor geopolitice.

Nu e o misiune ușoară — mai ales când compania are peste 800 de milioane de utilizatori săptămânal și o evaluare de 500 de miliarde de dolari, devenind cea mai valoroasă startup din lume.

Cum funcționează „poliția AI” din interiorul OpenAI

În ultimul an, OpenAI și-a construit o echipă internă de investigații digitale — o combinație de experți în securitate cibernetică, analiști de date și foști hackeri etici.

Aceștia urmăresc comportamentele neobișnuite din platformă: cereri suspecte, tipare de interogare, replici care pot trăda intenții ilegale.

Odată detectată o anomalie, contul este analizat și, dacă se confirmă o tentativă de abuz, suspendat definitiv.

OpenAI spune că preferă „să piardă un utilizator rău decât să pună în pericol milioane de oameni”.

DeepSeek, mărul discordiei

În raport apare menționat numele DeepSeek, un model de AI dezvoltat în China, despre care OpenAI spune că a fost invocat de unii utilizatori în cererile de automatizare.

Deși nu a fost acuzat direct, DeepSeek a devenit simbolul carierei chineze de a concura ChatGPT, iar referințele la el în contextul supravegherii au amplificat tensiunile.

Pentru Beijing, astfel de interdicții pot părea o nouă formă de izolare tehnologică; pentru Washington, sunt un pas firesc în protejarea infrastructurii digitale.

„E o linie subțire între securitate și cenzură,” observa recent un analist de la Georgetown Center for AI Policy.

De ce contează această poveste

Cazul arată cât de complicat devine rolul companiilor AI în politica globală.

Un simplu chatbot poate deveni un instrument de putere, iar deciziile etice se transformă rapid în decizii geopolitice.

OpenAI nu mai este doar o firmă de tehnologie, ci și un gardian al noilor frontiere digitale.

Pe scurt:

AI-ul nu doar că scrie texte și cod — acum are și propriul instinct de autoapărare.

Citește și

- Google lansează Gemini 2.5 Computer Use — primul său agent AI care poate naviga pe web ca un om

- Big Tech „donează” pentru Trump. Cum un ballroom de 200 de milioane a devenit noul lobby din Silicon Valley

- Jony Ive pregătește până la 20 de gadgeturi pentru OpenAI. „Vreau dispozitive care să ne facă mai fericiți, nu mai dependenți”

Partenerii noștri